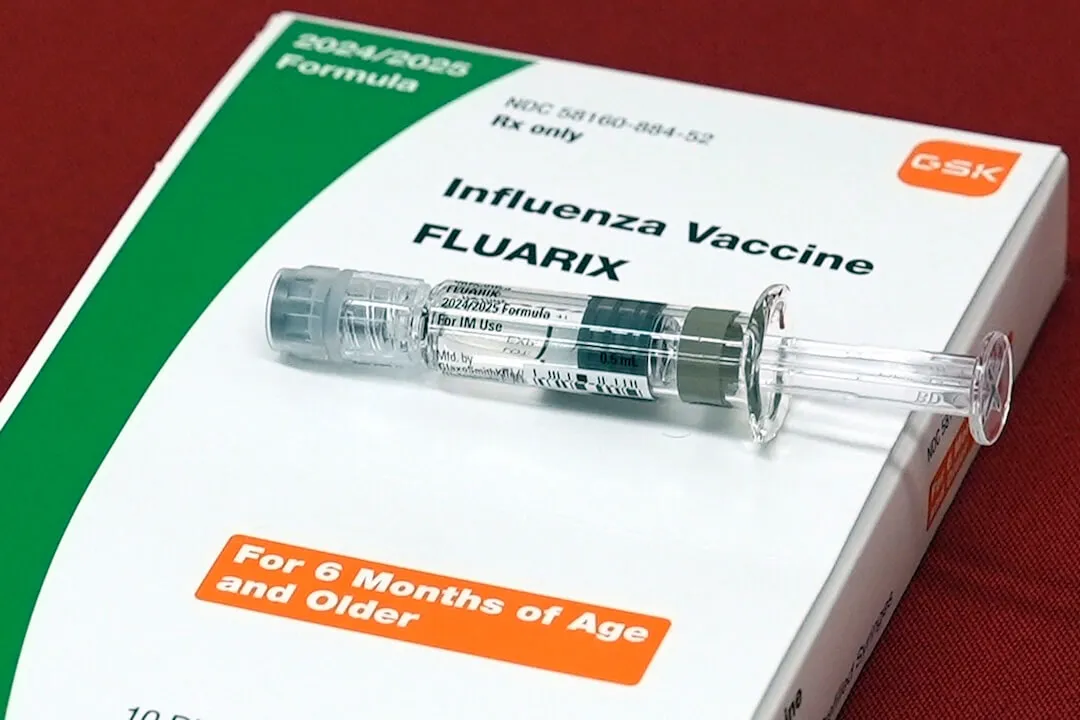

O relatório de saúde de RFK Jr. mostra como a IA coloca estudos falsos em pesquisas

O secretário de Saúde e Serviços Humanos, Robert F. Kennedy Jr., fala enquanto a secretária de Educação, Linda McMahon, ouve durante um evento da Comissão Make America Healthy Again na Sala Leste da Casa Branca, quinta-feira, 22 de maio de 2025, em Washington. (Foto AP/Jacquelyn Martin)

O secretário de Saúde e Serviços Humanos, Robert F. Kennedy Jr., fala enquanto a secretária de Educação, Linda McMahon, ouve durante um evento da Comissão Make America Healthy Again na Sala Leste da Casa Branca, quinta-feira, 22 de maio de 2025, em Washington. (Foto AP/Jacquelyn Martin)Os autores do relatório Make America Healthy Again, publicado pelo Secretário de Saúde e Serviços Humanos, Robert F. Kennedy Jr., elogiaram-no como uma avaliação marcante que fornece uma base científica comum para moldar a política de saúde.

Mas essa base científica parecia conter erros gerados por um provável culpado: a inteligência artificial generativa.

Pelo menos sete das citações do relatório foram problemáticas como NOTUS relatado pela primeira vez . Quatro continham títulos de artigos que não existem e três descaracterizaram as conclusões dos artigos.

Quando questionada sobre o relatório, a secretária de imprensa da Casa Branca, Karoline Leavitt atribuiu os erros a questões de formatação que não negam a substância do relatório. Quando questionado se a IA foi usada na produção do relatório, Leavitt transferiu-o para o Departamento de Saúde e Serviços Humanos.

O relatório MAHA foi atualizado online desde então. (Aqui está o versão arquivada .) O PolitiFact entrou em contato com o Departamento de Saúde e Serviços Humanos, mas não obteve resposta.

yaya gosselin idade

Os modelos de IA são treinados para imitar a linguagem que os humanos usam, prevendo uma palavra após a outra em uma sequência. Embora chatbots de IA como o ChatGPT muitas vezes tenham sucesso na produção de texto que parece ter sido escrito por um ser humano, muitas vezes não conseguem garantir que o que estão dizendo é factual.

As citações falsas foram formatadas corretamente, listadas em periódicos confiáveis e incluíam identificadores de objetos digitais ou DOIs que pareciam realistas.

Mas o fato de não existirem vários artigos citados é uma marca registrada das citações geradas por IA, que muitas vezes replicam a estrutura de referências acadêmicas sem vincular a fontes reais, disse Oren Etzioni, professor emérito e pesquisador de IA da Universidade de Washington.

O PolitiFact conversou com pesquisadores de inteligência artificial e neurociência sobre os sinais de alerta relacionados à IA do relatório.

Erros mostram marcas de alucinação de IA

Os pesquisadores disseram que a presença de artigos fabricados é provavelmente o resultado de alucinações de IA ou de resultados que podem parecer plausíveis, mas não são reais.

A IA está avançando rapidamente, mas ainda é propensa a alucinações. Quando solicitados a gerar referências acadêmicas, os modelos generativos de IA muitas vezes inventam algo se não encontrarem correspondências exatas, especialmente se solicitados a apoiar um ponto específico, disse Etzioni.

Steven Piantadosi, professor de psicologia e neurociência da Universidade da Califórnia em Berkeley, que lidera seu laboratório de computação e linguagem, disse que os modelos de IA não têm como saber o que é verdade ou o que conta como evidência.

Tudo o que eles fazem é combinar o padrão estatístico no texto que ele disse. É interessante e importante que eles consigam fazer isso muito bem, mas as dependências estatísticas entre os personagens não são o motivo pelo qual você deve construir uma política pública.

O Washington Post relatado que algumas citações incluíam oaicite em seus URLs, o que Usuários do ChatGPT relataram como texto que aparece em sua saída. (OpenAI possui ChatGPT.)

Descobertas sobre o uso de drogas para saúde mental por adolescentes e outras relacionadas a citações falsas

Mesmo nas citações legítimas do relatório, algumas descobertas foram deturpadas ou exageradas – outro erro comum às ferramentas generativas de IA que podem produzir com segurança resumos incorretos de pesquisas, disse Etzioni.

jennette mccurdy e namorada

A versão atualizada do relatório MAHA substituiu as citações falsas por fontes que apoiavam as suas conclusões e, em alguns locais, revisou a forma como apresentava as conclusões anteriormente ligadas às citações falsas. (Veja nosso planilha .)

Um dos artigos falsos sinalizados pela NOTUS foi intitulado Mudanças na saúde mental e no uso de substâncias entre adolescentes dos EUA durante a pandemia de COVID-19. A linha que o citava dizia: Aproximadamente 20-25% dos adolescentes relataram sintomas de ansiedade e 15-20% relataram sintomas depressivos, com as meninas apresentando taxas significativamente mais altas.

Um exame mais detalhado da citação mostra por que ela não é autêntica: pesquisar o título não produz um artigo real clicando no DOIS links na citação leva a uma página de erro dizendo DOI não encontrado e olhando para o volume JAMA Pediatrics e o número da edição referenciado leva a um artigo com título diferente e autores diferentes.

O relatório MAHA atualizado substituiu a citação por um Relatório de 2024 da KFF que afirmou que em 2021 e 2022 21% dos adolescentes relataram sintomas de ansiedade e 17% relataram sintomas de depressão.

O relatório original citava dois artigos inexistentes em uma seção sobre publicidade direta ao consumidor sobre o uso de drogas para TDAH por crianças e o uso de antidepressivos por adolescentes. O relatório disse que a publicidade de antidepressivos para adolescentes mostrava listas vagas de sintomas que se sobrepunham aos comportamentos típicos dos adolescentes e estava ligada a pedidos inadequados de antidepressivos por parte dos pais.

A nova versão do relatório agora diz que a publicidade do DTC incentiva um maior uso de medicamentos psicotrópicos em adolescentes, incluindo classes de ansiolíticos, antipsicóticos e antidepressivos, agora citando um Estudo de 2006 que utilizou dados de 1994 a 2001. Os autores acreditavam que a publicidade direta ao consumidor desempenhou um papel no incentivo ao maior uso de psicotrópicos.

Outra descoberta no relatório da MAHA sobre prescrições de medicamentos para asma disse que cerca de 25-40% dos casos leves são prescritos em excesso, citando um artigo inexistente. O pneumologista pediátrico Dr. Harold J. Farber, listado como o suposto primeiro autor do artigo, disse à NOTUS que isso era uma generalização excessiva de sua pesquisa.

O relatório atualizado removeu esses números. Agora lê-se Há evidências de prescrição excessiva de corticosteróides orais para casos leves de asma.

O incidente do relatório MAHA destaca os riscos de incluir conteúdo gerado por IA em relatórios oficiais do governo sem revisão humana.

Se ferramentas de IA fossem usadas para gerar citações para um relatório federal que levantasse sérias questões de responsabilidade. Sem divulgação clara ou processos de verificação, não há como os leitores saberem se a informação é baseada em evidências reais, disse Etzioni. Em questões de saúde pública, especialmente envolvendo crianças e saúde mental, estes lapsos são particularmente preocupantes.

Esta verificação de fatos foi originalmente publicado por PolitiFact que faz parte do Instituto Poynter. Veja as fontes para esta verificação de fatos aqui .